Por Brian Merchant em 13 de dezembro de 2018 no site Gizmodo.

|

| Gizmodo - UOL |

A inteligência artificial já está começando a sair do nosso controle, alerta um novo relatório feito por pesquisadores de ponta. Não tanto no sentido da Skynet, mas mais no sentido de “empresas de tecnologia e governos já estão usando IA de maneiras que aumentam a vigilância e marginalizam ainda mais populações vulneráveis”.

Na semana passada, o AI Now Institute, afiliado à Universidade de Nova York e lar de grandes pesquisadores de IA com o Google e a Microsoft, divulgou um relatóriodetalhando, basicamente, o estado da IA em 2018 e a série de tendências desconcertantes que se desenvolvem no campo.

O que definimos amplamente como IA — aprendizado de máquina, sistemas automatizados etc. — está sendo desenvolvido atualmente mais rápido do que nosso sistema regulatório está preparado para lidar, diz o relatório. E ela ameaça consolidar o poder nas empresas de tecnologia e governos opressores que implantam a IA, tornando praticamente todos os outros mais vulneráveis a seus vieses, suas capacidades de vigilância e suas inúmeras disfunções.

O relatório contém dez recomendações para os legisladores, todas elas aparentemente válidas, assim como um diagnóstico das tendências mais potencialmente destrutivas. “Os governos precisam regular a IA”, estimula a primeira recomendação, “expandindo os poderes das agências setoriais específicas para supervisionar, auditar e monitorar essas tecnologias por domínio”. Um Departamento de IA enorme ou algo assim que tente regular o campo em grande escala não será suficiente, advertem os pesquisadores — o relatório sugere que os reguladores sigam exemplos como o da Administração Federal de Aviação dos EUA e lidem com a IA à medida que ela se manifesta campo por campo.

Mas o documento também transmite uma avaliação sucinta das principais áreas problemáticas da IA na sua forma atual em 2018. Conforme detalhado pelo AI Now, elas são:

- A lacuna de responsabilidade entre aqueles que constroem os sistemas de IA (e lucram com eles) e aqueles que sofrem o impacto dos sistemas (você e eu) está crescendo. Não gosta da ideia de ser submetido a sistemas artificialmente inteligentes que coletam seus dados pessoais ou determinam vários desfechos para você? Que pena! O relatório conclui que o recurso que a maioria dos cidadãos públicos tem para lidar com os sistemas muito artificialmente inteligentes que os podem afetar está encolhendo, não crescendo.

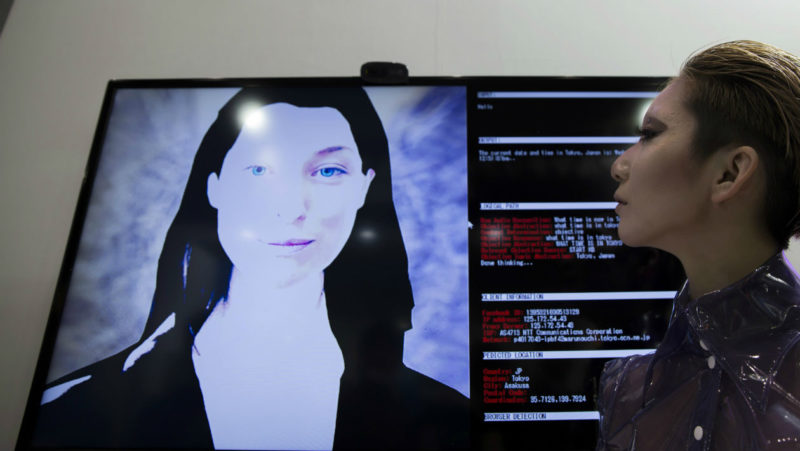

- A IA está sendo usada para amplificar a vigilância, muitas vezes de formas horríveis. Se você acha que as capacidades de vigilância da tecnologia de reconhecimento facial são perturbadoras, espere até ver o seu colega ainda menos escrupuloso, a “affect recognition“, algo como reconhecimento de emoções. Sam Biddle, do Intercept, faz uma boa descrição do tratamento de “affect recognition” no relatório, que é basicamente uma frenologia moderna, praticada em tempo real.

- O governo está adotando softwares de tomadas de decisão autônomos em nome da economia de custos, mas esses sistemas são muitas vezes um desastre para os desfavorecidos. Desde sistemas que pretendem agilizar os processos de solicitação de benefícios online até aqueles que afirmam ser capazes de determinar quem é elegível para moradia, os chamados sistemas ADS são capazes de carregar viés e erroneamente rejeitar candidatos com base em argumentos infundados. Como Virginia Eubanks detalha em seu livro Automating Inequality, as pessoas que esses sistemas reprovam são aquelas que são menos capazes de reunir o tempo e os recursos necessários para resolvê-los.

- O teste de IA “na selva” já está desenfreado. “O Vale do Silício é conhecido por sua mentalidade de ‘mova-se rapidamente e quebre as coisas'”, observa o relatório, e isso está levando as empresas a testarem sistemas de IA no setor público — ou lançarem-nos no espaço do consumidor completamente — sem supervisão substancial. O histórico recente do Facebook — primeiro evangelizador de IA e da ideia de mover-se rápido e quebrar as coisas — é exemplo suficiente de por que essa estratégia pode ser desastrosa.

- As soluções tecnológicas para sistemas de IA preconceituosos ou problemáticos estão se mostrando inadequadas. O Google fez barulho quando anunciou que estava abordando a ética do aprendizado de máquina, mas esforços como esse já estão se mostrando muito limitados e tecnicamente orientados. Os engenheiros tendem a pensar que podem corrigir problemas de engenharia com, bem, mais engenharia. Mas o que é realmente necessário, argumenta o relatório, é uma compreensão muito mais profunda da história e dos contextos sociais dos conjuntos de dados com os quais os sistemas de IA são treinados.

Vale a pena conferir o relatório completo, tanto para dar uma passada sobre a variedade de maneiras como a inteligência artificial entrou na esfera pública — colidindo com o interesse público — em 2018 quanto para ver a receita detalhada de como nossas instituições podem controlar essa situação complicada.

Nenhum comentário:

Postar um comentário