Redação do Site Inovação Tecnológica - 28/06/2019

Um novo tipo de memória eletrônica, com seu consumo de energia ultrabaixo, promete dar vida nova a computadores e aparelhos eletrônicos portáteis em geral.

Ofogh Tizno e seus colegas da Universidade Lancaster, no Reino Unido, afirmam que sua "memória universal" pode reduzir o consumo de energia das centrais de dados em um quinto, além de permitir que os computadores deem boot instantâneo, já que ela não perde os dados na ausência de eletricidade.

"Uma memória universal, que armazena dados de forma robusta e que podem ser facilmente alterados, é amplamente considerada inviável ou até mesmo impossível, mas este dispositivo demonstra suas propriedades contraditórias," disse o professor Manus Hayne, coordenador da equipe.

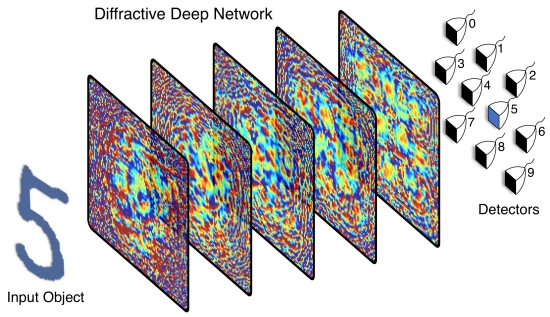

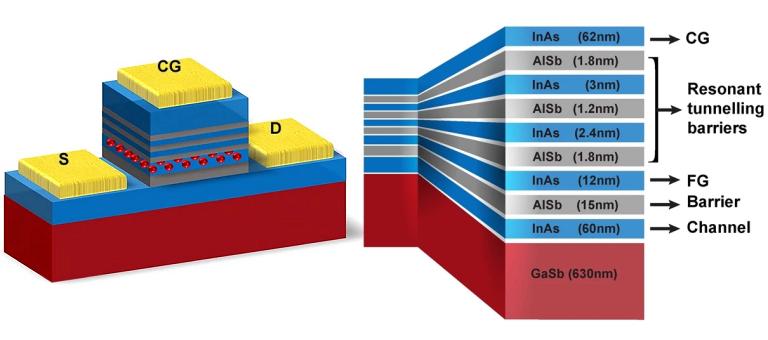

Fazer o impossível envolveu usar a mecânica quântica para resolver o dilema de escolher entre armazenamento de dados estável e de longo prazo e a gravação e apagamento de dados usando pouca energia.

Memória universal

Embora a gravação de dados nas memórias DRAM atuais seja rápida e gaste pouca energia em cada operação, os dados são voláteis e devem ser continuamente atualizados para evitar que sejam perdidos - como isso ocorre a cada poucos nanossegundos, a conta de energia sobe rapidamente. As memórias do tipo flash, por sua vez, armazenam dados de forma robusta, mas consomem muita energia e se deterioram, além de a gravação e o apagamento serem lentos, tornando-as inadequadas para funcionar como memória de trabalho.

"O ideal é combinar as vantagens de ambos sem seus inconvenientes, e é isso que demonstramos. Nosso dispositivo tem um tempo de armazenamento de dados intrínseco que é previsto para exceder a idade do Universo, mas pode gravar ou excluir dados usando 100 vezes menos energia do que a DRAM," disse o professor Hayne.

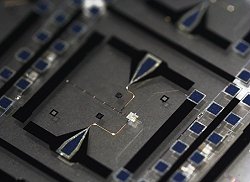

O protótipo, construído com uma combinação de três semicondutores - arseneto de índio (InAs), antimoneto de gálio (GaSb) e antimoneto de alumínio (AlSb) - alcançou uma retenção de dados de 104 segundos e operou a uma tensão abaixo dos 2,6 volts.

O entusiasmo da equipe com sua "memória universal" tem fundamento: Várias empresas de semicondutores já manifestaram interesse em licenciar a patente do novo componente.

Por outro lado, "memórias universais" têm sido anunciadas há mais de uma década, incluindo versões "revolucionárias" como as memórias de conteúdo endereçável e, mais recentemente, as memórias antiferromagnéticas e as memórias com três bits por célula.

Artigo: Room-temperature Operation of Low-voltage, Non-volatile, Compound-semiconductor Memory Cells

Autores: Ofogh Tizno, Andrew R. J. Marshall, Natalia Fernández-Delgado, Miriam Herrera, Sergio I. Molina, Manus Hayne

Revista: Nature Scientific Reports

Vol.: 9, Article number: 8950

DOI: 10.1038/s41598-019-45370-1