Por InfoChannel em 05/06/2020

Diante da guerra que ultrapassa fronteiras contra a ameaça da Covid-19, o Coronavírus, muitos profissionais, empresas e até setores têm se unido para contribuir de alguma forma e tentar frear o avanço deste vírus. Neste sentido, a Associação Brasileira de Inteligência Artificial -Abria, destaca os benefícios que a tecnologia de IA pode oferecer a esta guerra e seus membros se colocam a disposição para o desenvolvimento de projetos emergenciais.

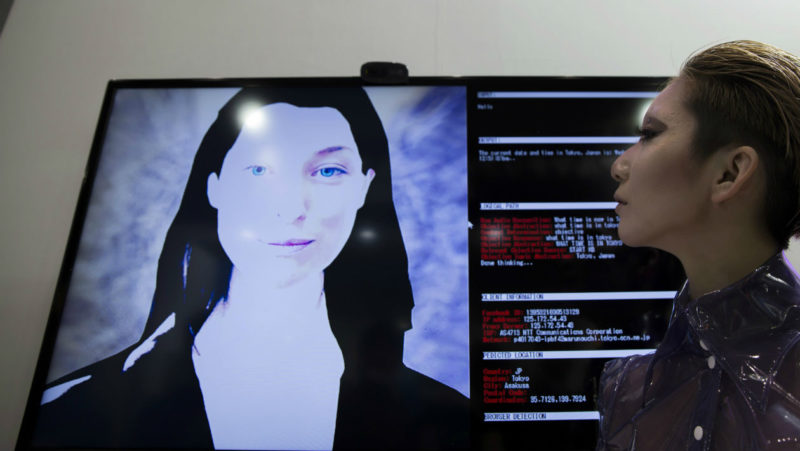

Uma ferramenta de inteligência artificial identificou a epidemia de Coronavírus muito antes de virar algo de conhecimento público. A plataforma de IA BlueDot, que faz mapeamento de notícias, rastreia pesquisas de saúde e checa comunicados oficiais, emitiu um alerta para se evitar a região de Wuhan, antes mesmo que a própria OMS se pronunciasse.

“Este é um excelente exemplo do poder que a Inteligência Artificial tem para ajudar a coletividade. Existe ainda uma enorme gama de possibilidades para utilizarmos a IA em benefício de todos não só neste momento de crise, como em eventuais novos problemas”, afirma Rodrigo Scotti, chairman da Abria e CEO da Nama.

Para facilitar o contato entre empresas, serviços de IA, órgãos públicos e entidades relevantes para a batalha contra o novo Coronavírus, a Abria lançou um formulário para coletar projetos e outras task-forces para ajudar com base em escala operacional, datasets, análise e predição, automação de processos, comunicação em massa, logística & distribuição, serviços de APIs, projetos open source, créditos na nuvem, entre outras ideias que possam surgir.

“Estamos em busca de soluções de IA simples e que possam ser rapidamente implementadas para ajudar neste combate em nosso país. Por isso estamos rodando este formulário para centralizar essas ações – que usam IA, e em contato com outras associações e entidades para formar um plano de ação”, afirma Fernando Lopes, conselheiro da Abria e sócio da Mvisia.

Área da saúde é um dos focos do setor

No último ano, os membros da Abria realizaram diversos MeetUps, sendo que um dos mais relevantes ocorreu no Eretz, incubadora de Startups do Hospital Albert Einstein. “Nessa oportunidade, todos nós discutimos muito o uso da IA para diagnóstico e prevenção de doenças. A partir disso, criamos o comitê de HealthTech da Abria”, afirma Valter Wolf, diretor executivo da Associação.

A Abria também enviou a sua contribuição para a consulta pública para a Estratégia Brasileira de Inteligência Artificial, lançada pelo Ministério da Ciência, Tecnologia, Inovações e Comunicações – MCTIC, no fim de 2019. “O uso de dados pessoais e aplicação ética da inteligência artificial foi um dos pontos mais comentados pelos membros. Isso tem impacto direto na área da saúde, principalmente quando se fala nos dados do prontuário médico do paciente”, completa Wolf.

“O momento é de concentrar todos os nossos esforços de maneira conjunta. Em hospitais e clínicas, a IA pode ter um papel fundamental para triagem, tirar dúvidas sobre sintomas específicos, facilitar o agendamento de consultas, etc. Além disso, como o impacto da recessão afeta a todos os setores, a tecnologia pode reduzir a perda financeira de companhias que tiveram impacto em suas operações. É importante comunicar que a Abria, bem como todos os seus membros, estão à disposição para desenhar o melhor projeto e entregá-lo no menor tempo possível”, finaliza Scotti.